GPT-4V ist eine Multimodal-Modell von OpenAI, das Bildinputs von Nutzern analysieren und Fragen dazu beantworten kann. Es kombiniert die Fähigkeiten von GPT-4, einem mächtigen und kreativen Sprachmodell, mit visuellen Fähigkeiten, was eine breite Palette von Anwendungen ermöglicht, die sowohl Sprach- als auch Visionfähigkeiten erfordern.

Inhaltsverzeichnis

Warum ist GPT-4V so spannend?

Die Kombination von Text- und Bildverstehen in einem einzigen Modell ist ein Durchbruch in der KI. Durch die Verarbeitung von Bildern zusammen mit Text können völlig neue Arten von Aufgaben und Anwendungen angegangen werden, die zuvor nicht möglich waren. Dies eröffnet ein neues Feld für Forschung und Entwicklung im Bereich der künstlichen Intelligenz.

Warum jeder davon spricht

Die Fähigkeit, sowohl Bilder als auch Text zu verstehen und zu verarbeiten, macht GPT-4V zu einem spannenden Fortschritt in der KI-Welt. Diese Weiterentwicklung erweitert die Einsatzmöglichkeiten von KI-Modellen erheblich und bringt sie einen Schritt näher an eine menschenähnliche Verarbeitung von Informationen heran. Die Integration von visuellem Verständnis in ein bereits leistungsfähiges Sprachmodell wie GPT-4 ermöglicht es, komplexe Aufgaben zu lösen, die sowohl visuelle als auch sprachliche Informationen benötigen. Dieses erweiterte Verständnis und die daraus resultierenden Anwendungsmöglichkeiten sind der Grund, warum viele in der Community gespannt auf die Entwicklung und den Einsatz von GPT-4V blicken

Was gibt es bei GPT-4V zu beachten?

Wie bei jeder neuen Technologie gibt es auch bei GPT-4V Herausforderungen und Limitierungen. Die genaue Interpretation und Verarbeitung von Bildinformationen zusammen mit Text ist eine komplexe Aufgabe und GPT-4V mag in einigen Aspekten noch nicht perfekt sein. Es ist wichtig, sich dieser Limitierungen bewusst zu sein und zu verstehen, wie sie die Anwendung des Modells beeinflussen können.

Die Interpretation von Bildern kann zu Illusionen und Halluzinationen führen, wenn das Modell falsche oder ungenaue Informationen aus den visuellen Daten extrahiert. Dies ist ein kritischer Punkt, der berücksichtigt werden muss, wenn man die Leistung und die Einsatzmöglichkeiten von GPT-4V bewertet.

Die 7 Anwendungsfälle von GPT-4V

In den folgenden Abschnitten könnten die spezifischen Anwendungsfälle von GPT-4V weiter untersucht und erklärt werden, wie sie in den verschiedenen Kategorien wie Beschreiben, Interpretieren, Empfehlen, Umwandeln, Extrahieren, Assistieren und Bewerten eingesetzt werden können. Mit diesen Informationen können Sie einen tiefen Einblick in die spannende Welt von GPT-4V und seine vielfältigen Anwendungsmöglichkeiten geben.

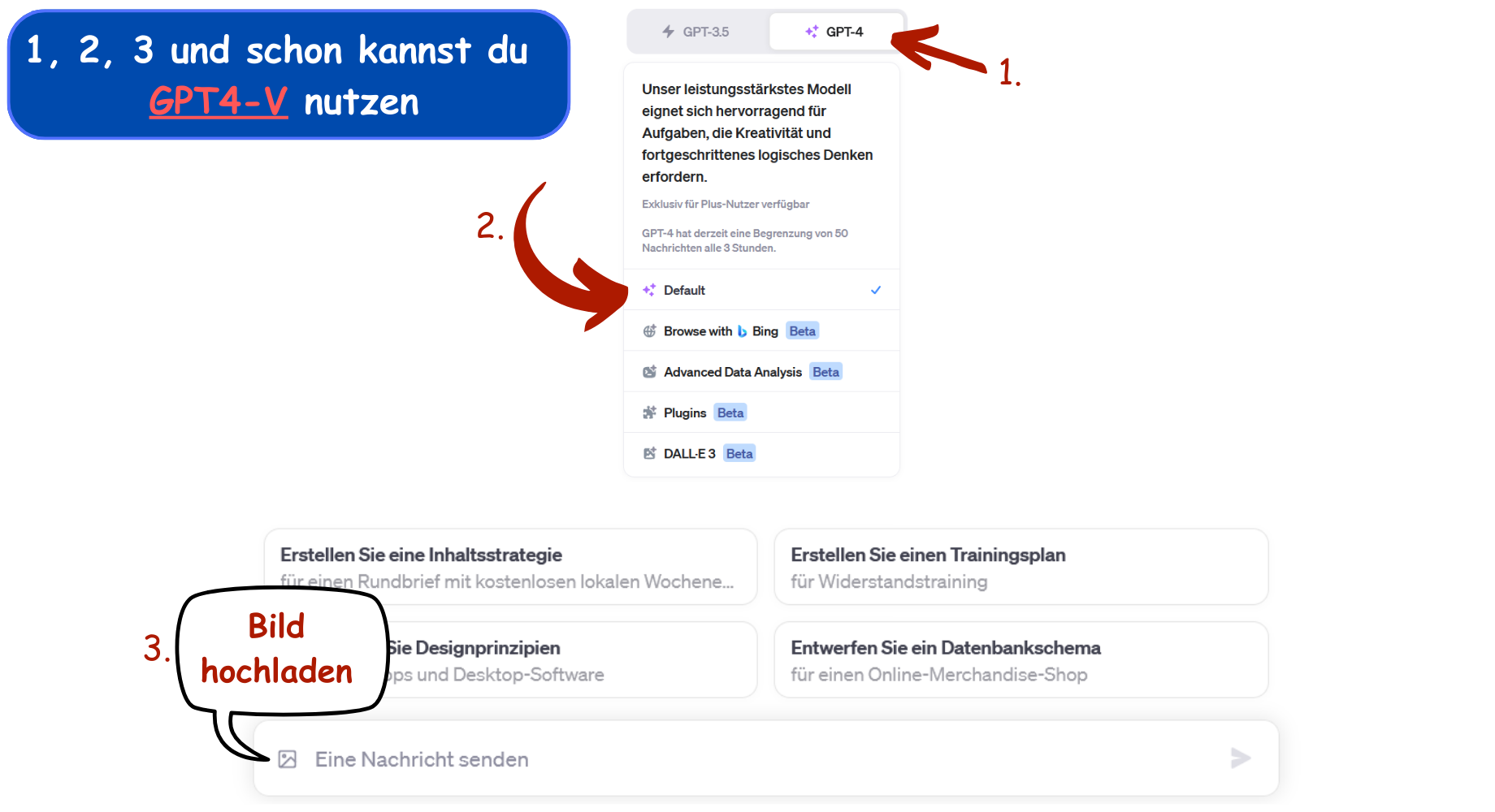

So findest du GPT-4V

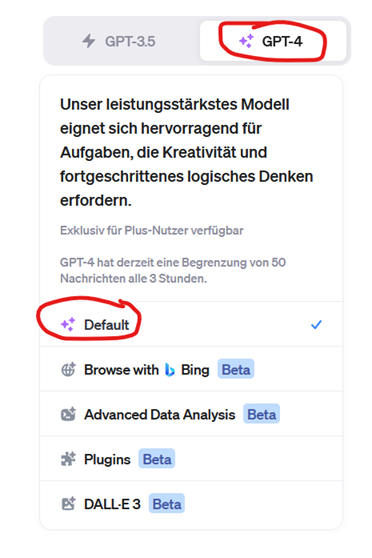

Zunächst einmal steht das Visionmodell nur für zahlende Kunden zur Verfügung. Dort dann einfach oben auf GPT-4 klicken und Default auswählen.

Anschließend taucht unten im Chatdialog ein kleines Icon auf, über das Bilder hochgeladen werden können.

Sollte das Icon für dich nicht sichtbar sein, so bist du noch nicht für diese Funktion freigeschaltet. Die Funktion wird erst nach und nach allen Benutzer zur Verfügung gestellt.

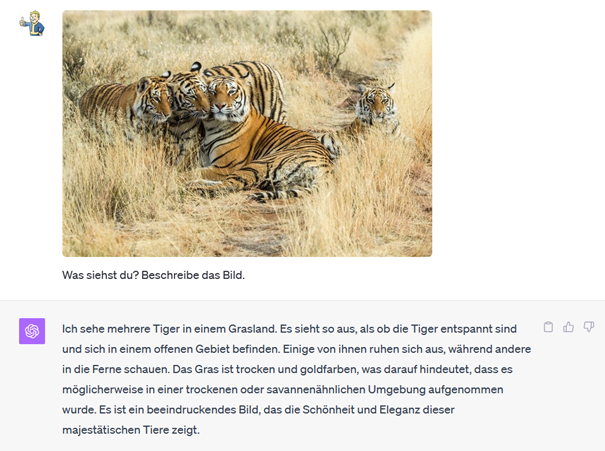

1. Beschreiben

Zunächst geht es um den Basisfall: Beschreiben Sie einfach, was auf einem Bild zu sehen ist. Die Beispiele, die ich gesehen habe, waren entweder die Identifikation eines einzelnen Objekts oder eine Auflistung von vielen Objekten. Man bekommt den Eindruck als könnte GPT4-V tatsächlich sehen.

Weitere Beispiele: Identifizieren von Tieren, Pflanzen, Gebäuden … , „Welche Objekte sind auf diesem Foto?“, „Wo wurde dieses Foto aufgenommen?“

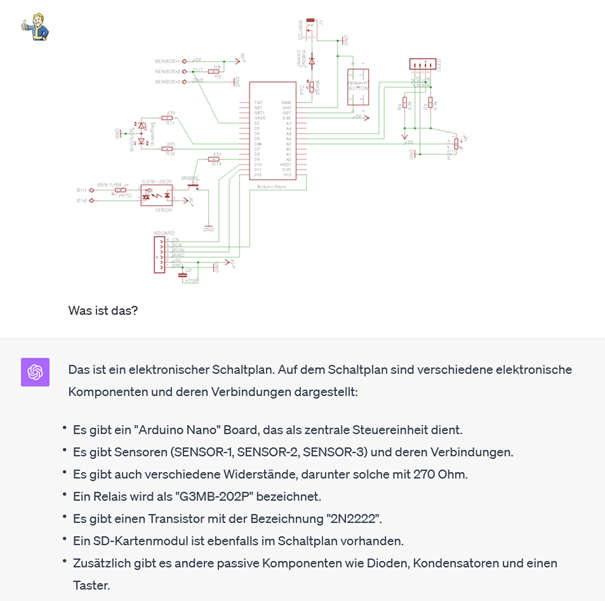

2. Interpretieren

Das ist die größte Kategorie der Gruppe. Hier wird das Modell die Bedeutung innerhalb eines Fotos erläutern oder mehr Kontext hinter einem Bild liefern. Diese Anwendungsfälle nehmen ein Bild und gehen mit einer Synthese eine Ebene tiefer.

Weitere Beispiele: Technische Interpretation von Flammendiagrammen, Schematische Interpretation, Erklärung von Twitter-Threads, Vorhersehung von Autounfällen, Verständnis von Schaltplänen.

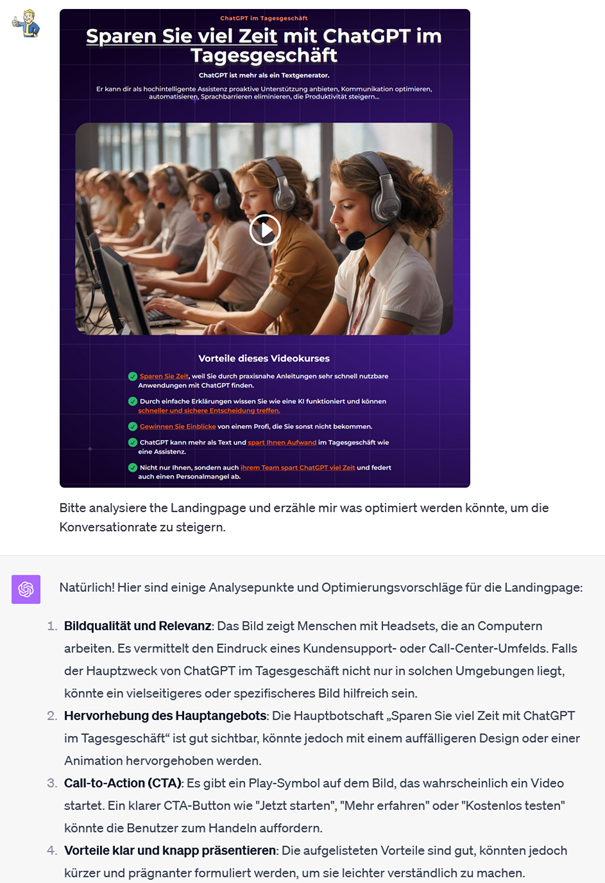

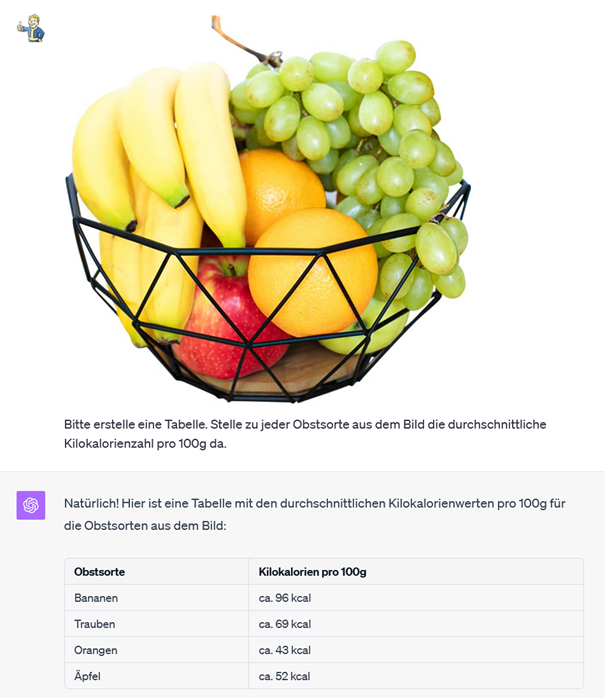

3. Empfehlen

Hier haben wir zwei große Kategorien: Kritiken und Empfehlungen. Bei Kritiken wird der Benutzer GPT-4V nach seiner Meinung zu einem Bild fragen. Dies könnte ein Gemälde, eine Landingpage, ein Logo usw. sein.

Benutzer werden GPT-4V auch bitten, ihre Meinung in Form einer Empfehlung abzugeben. Welches Obststück ist besser? Welches Gericht von der Speisekarte sollte ich nehmen?

Weitere Beispiele: Essen-Empfehlungen, Feedback zu Webseiten (davon gibt es massenhaft), Feedback zu Gemälden.

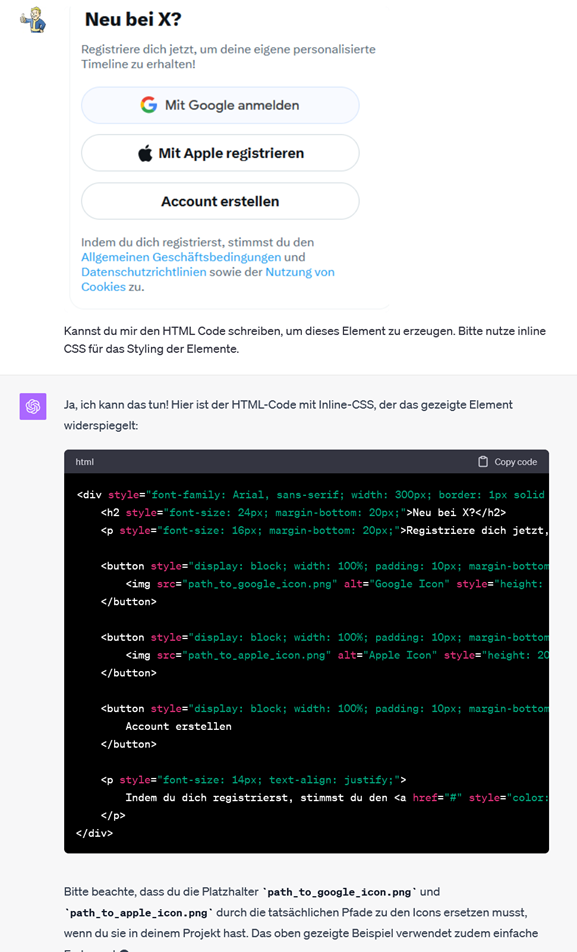

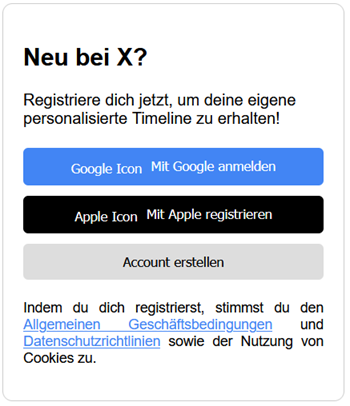

4. Umwandeln

Hier verwandelt das Modell Bilder in andere Formen (Code, Erzählung usw.) oder generiert etwas Neues. Diese Kategorie hat massive Auswirkungen.

Die Schlüsselerkenntnis ist, dass Sie Modelle verwenden können, um Konfigurationsdateien zu generieren – die die Grundlage für fast alle Anwendungsschnittstellen sind.

Hier das Ergebnis:

Sehr beeindruckend!

Weitere Beispiele: Figma-Bildschirme > Code, Adobe Lightroom-Einstellungen, Werbetextvorschläge basierend auf einer Webseite.

5. Extrahieren

Verwende das Modell, um strukturierte Daten basierend auf Entitäten innerhalb eines Bildes zu extrahieren. Ich liebe diese Methode, da auf diese Weise unstrukturierte Daten strukturiert werden.

Weitere Beispiele: Strukturierte Daten aus einem Führerschein extrahieren, Strukturierte Elemente aus einem Bild extrahieren, Handschrift extrahieren, Gewürzregal-Inhalte extrahieren.

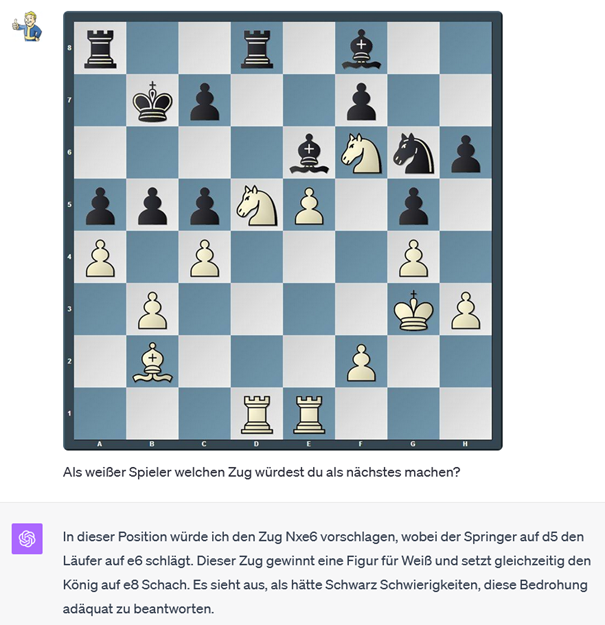

6. Assistieren

Verwende das Modell, um Lösungen basierend auf einem Bild vorzuschlagen. Das Modell wird interpretieren, was in einem Bild passiert, und dann Vorschläge machen, was als nächstes zu tun ist.

Dies ähnelt der Art und Weise, wie das Modell verwendet werden kann, um dir als Assistenz zu dienen. Nur jetzt kann deine Assistenz sogar sehen.

Weitere Beispiele: Excel Formel-Helfer, „Finde meine Brille“ (diese Idee liebe ich), Live-Pokerberatung, Videospiel-Empfehlungen.

7. Bewerten

Subjektive Beurteilung basierend auf dem Bild. Hierbei wird das Modell den Inhalt des Bildes bewerten oder eine subjektive Meinung abgeben.

Weitere Beispiele: Hundesüßheits-Bewerter, Bounding-Box-Bewerter, Thumbnail-Testen.

Praktischer Nutzen

Mit dem Wissen über die verschiedenen Anwendungsmöglichkeiten von GPT-4V sind Sie nun besser darauf vorbereitet, die Herausforderungen anzugehen, denen Sie oder Ihre Kunden gegenüberstehen. Die Fähigkeit, sowohl Text als auch Bilder zu verarbeiten, ermöglicht eine breite Palette von Lösungen, die bisher möglicherweise unerreichbar waren. Anstatt sich auf die Suche nach neuen Problemen zu begeben, könnte es lohnenswert sein, die bereits existierenden Probleme, die Sie und Ihre Kunden haben, erneut zu betrachten und zu sehen, ob GPT-4V dabei helfen kann, sie zu lösen.

Wenn Sie nicht sicher sind, wo Sie anfangen sollen, lassen Sie Ihrer Neugier freien Lauf, experimentieren Sie und haben Sie Spaß dabei. Die breite Palette von Anwendungsmöglichkeiten, die GPT-4V bietet, ist ein fruchtbarer Boden für Exploration und Innovation. Nutzen Sie diese Gelegenheit, um neue Lösungen zu entwickeln, die den Bedürfnissen Ihrer Kunden besser entsprechen.

Fazit

GPT-4V markiert einen signifikanten Fortschritt in der Entwicklung von KI-Technologie. Die Fähigkeit, unstrukturierte Daten in strukturierte Informationen umzuwandeln, besonders in der Kategorie des Extrahierens, öffnet viele Türen für die Zukunft. Persönlich bin ich von der Extraktionskategorie begeistert, da wir nun die Fähigkeit haben, unstrukturierte Daten zu strukturieren.

Die Zukunft verspricht spannende Entwicklungen, da Modelle wie GPT-4V weiter verfeinert und in einer Vielzahl von Anwendungen eingesetzt werden. Die Verbindung von Sprach- und Bildverstehen in einem einzigen Modell zeigt die Richtung an, in die sich die KI-Technologie bewegt. Die Einsatzmöglichkeiten von GPT-4V sind weitreichend und die kommenden Entwicklungen werden sicherlich noch mehr faszinierende Anwendungen hervorbringen, die unsere Art zu arbeiten und Probleme zu lösen, verändern werden.

Mit einem soliden Verständnis von GPT-4V und seinen Anwendungsmöglichkeiten sind Sie gut positioniert, um die Vorteile dieser Technologie für sich und Ihre Kunden zu nutzen. Die Reise in die Welt der multimodalen KI-Modelle ist spannend und voller Potenzial. Nutzen Sie diese Gelegenheit, um innovative Lösungen zu erforschen und zu entwickeln, die echte Probleme lösen und echten Wert schaffen.

FAQs

Was ist GPT-4V und was macht es besonders?

GPT-4V ist ein Multimodal-Modell von OpenAI, das Bildinputs analysieren und Fragen dazu beantworten kann. Es kombiniert die Fähigkeiten von GPT-4, einem leistungsfähigen und kreativen Sprachmodell, mit visuellen Fähigkeiten, was eine breite Palette von Anwendungen ermöglicht, die sowohl Sprach- als auch Visionfähigkeiten erfordern.

Warum ist die Kombination von Text- und Bildverstehen in GPT-4V ein Durchbruch?

Die Kombination ermöglicht es, völlig neue Arten von Aufgaben und Anwendungen anzugehen, die zuvor nicht möglich waren. Es eröffnet ein neues Feld für Forschung und Entwicklung im Bereich der KI und erweitert die Einsatzmöglichkeiten von KI-Modellen erheblich, da sie nun eine menschenähnliche Verarbeitung von Informationen durchführen können.

Welche Herausforderungen und Limitierungen gibt es bei GPT-4V?

Die genaue Interpretation und Verarbeitung von Bildinformationen zusammen mit Text ist eine komplexe Aufgabe und GPT-4V mag in einigen Aspekten noch nicht perfekt sein. Außerdem kann die Interpretation von Bildern zu Illusionen und Halluzinationen führen, wenn das Modell falsche oder ungenaue Informationen aus den visuellen Daten extrahiert.

Wie kann ich auf GPT-4V zugreifen und es nutzen?

GPT-4V steht zunächst nur für zahlende Kunden zur Verfügung. Nach dem Zugang können Sie auf GPT-4 klicken und „Default“ auswählen, woraufhin ein kleines Icon im Chatdialog erscheint, über das Bilder hochgeladen werden können. Wenn das Icon nicht sichtbar ist, sind Sie noch nicht für diese Funktion freigeschaltet.

In welchen Anwendungsbereichen kann GPT-4V genutzt werden?

GPT-4V kann in verschiedenen Kategorien wie Beschreiben, Interpretieren, Empfehlen, Umwandeln, Extrahieren, Assistieren und Bewerten eingesetzt werden. Es bietet vielfältige Möglichkeiten von der Identifikation von Objekten auf Bildern über die technische Interpretation von Diagrammen bis hin zur Generierung von Code basierend auf visuellen Eingaben.

Hier dein ChatGPT Vision – Cheat Sheet

Ein Klick auf das Bild gibt dir das PDF, dass du speichern, teilen und ausdrucken kannst, um mit GPT4-V nicht nur Zeit zu sparen, sondern auch eine Menge Freude zu haben.