Von tiefgreifenden Verbesserungen in der Effizienz und Benutzerfreundlichkeit bis hin zu bahnbrechenden Fortschritten in der multimodalen KI-Kommunikation – diese Aktualisierungen sind ein Meilenstein in der Annäherung an das Konzept einer Allgemeinen Künstlichen Intelligenz (AGI). In dieser Einleitung nehmen wir Sie mit auf eine Reise durch die aufregenden Neuerungen, die OpenAI mit dem neuesten Update von ChatGPT vorgestellt hat. Tauchen Sie ein in eine Welt, in der KI nicht nur ein Werkzeug ist, sondern ein kollaborativer Partner, der das menschliche Potenzial entfesseln hilft.

Inhaltsverzeichnis

Überblick über den OpenAI DevDay

Das OpenAI DevDay Ereignis war ein bedeutendes Event, bei dem eine Reihe von Updates und neuen Entwicklungen vorgestellt wurden. Zu den Highlights gehörten die Einführung von GPT-4 Turbo, einem effizienteren Modell mit einem erweiterten Kontextfenster von 128.000 Zeichen, das kostengünstiger ist als seine Vorgänger. Entwickler können nun dank neuer API-Funktionen komplexere Funktionen nutzen und konsistente JSON-Antworten erhalten. Ein neues Feature ermöglicht die Integration eines KI-gestützten Assistenten in Webseiten, der Aufgaben wie Code-Interpretation, Dokumentenabruf und API-Aufrufe übernehmen kann. OpenAI präsentierte auch die Vision API für DALL-E 3 und neue Text-to-Speech-Optionen, was den Vorstoß in den multimodalen Bereich markiert. Zudem wurden maßgeschneiderte KI-Modelle für große Organisationen und eine Reduzierung der Preise für verschiedene Modelle angekündigt, was KI-Technologien zugänglicher macht.

Vorstellung von GPT-4 Turbo

Was ist neu bei GPT-4 Turbo?

Zu den neuen Funktionen von GPT-4 Turbo zählt die erhöhte Effizienz, die es ermöglicht, komplexe Anfragen mit einem erweiterten Kontext zu verstehen und zu beantworten. Dieses Modell ist eine verbesserte Version des vorherigen GPT-4, das bereits eine beeindruckende Leistungsfähigkeit bot, aber mit GPT-4 Turbo hat OpenAI die Latenzzeiten verringert und die Handhabung großer Datenmengen optimiert. Dadurch können Entwickler leistungsfähige, KI-gestützte Anwendungen kostengünstiger als zuvor erstellen. Insbesondere die Erweiterung des Kontextfensters ist ein großer Schritt in Richtung komplexerer und natürlicher Dialoge mit KI-Modellen.

Leistung und Wirtschaftlichkeit

GPT-4 Turbo ist eine Weiterentwicklung des GPT-4 Modells, das speziell für Entwickler eine wirtschaftlichere Nutzung ermöglicht. GPT-4 Turbo ist in der Lage, mehr als 300 Seiten Text in einem einzigen Prompt zu verarbeiten und hat ein Wissen über weltweite Ereignisse bis April 2023. OpenAI hat die Leistung optimiert und bietet GPT-4 Turbo zu einem 3-fach günstigeren Preis für Eingabetoken und einem 2-fach günstigeren Preis für Ausgabetoken im Vergleich zu GPT-4 an. GPT-4 Turbo ist derzeit als Vorschauversion für zahlende Entwickler verfügbar, indem sie gpt-4-1106-preview in der API verwenden, und OpenAI plant, das stabile, produktionsreife Modell in den kommenden Wochen zu veröffentlichen.

Verfügbarkeit

penAI hat die Verfügbarkeit von GPT-4 Turbo für Entwickler durch die Bereitstellung einer Vorschauversion erweitert. Entwickler, die für ihre Dienste zahlen, können diese fortschrittlichere Version nutzen, indem sie gpt-4-1106-preview in der API angeben. Die Veröffentlichung des stabilen, produktionsbereiten Modells ist in den kommenden Wochen geplant. Diese Schritte zielen darauf ab, die Anwendung von KI in verschiedenen Geschäftsbereichen zu verbreiten und Entwicklern zu ermöglichen, schneller innovative Anwendungen zu kreieren.

KI-gestützte Assistenten

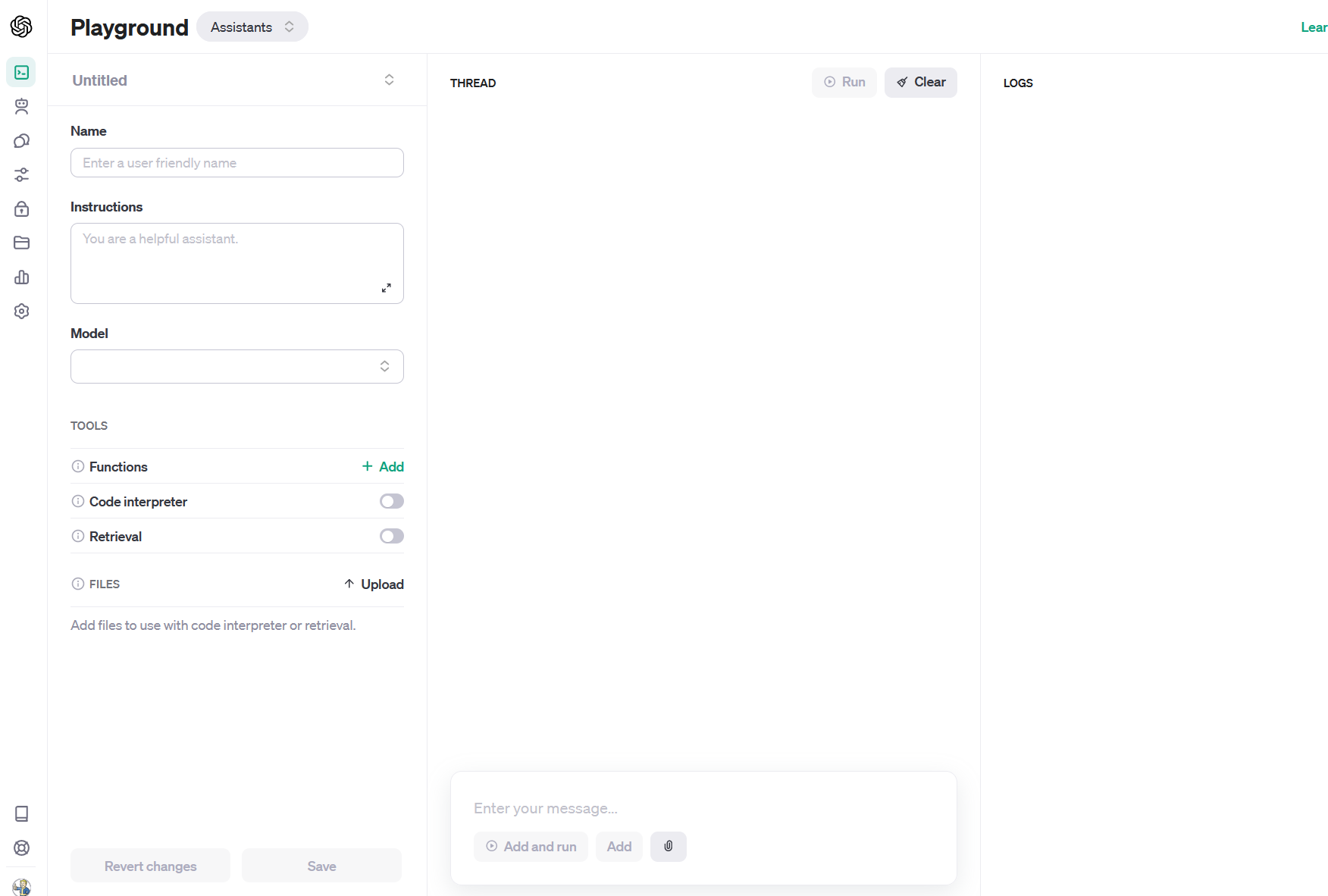

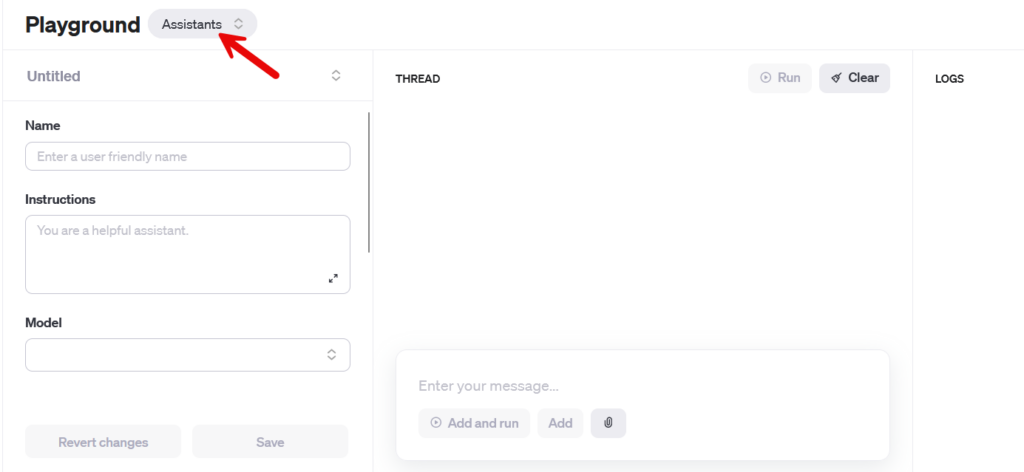

Die Assistants API ist eine neu eingeführte Schnittstelle von OpenAI, die Entwicklern ermöglicht, spezialisierte KI-Assistenten zu erstellen. Diese Assistenten können spezifische Anweisungen befolgen, zusätzliches Wissen nutzen und Modelle sowie Werkzeuge aufrufen, um Aufgaben auszuführen. Zu den Kernfunktionen gehören der Code Interpreter, der Python-Code in einer abgesicherten Umgebung ausführen kann, Retrieval, das externe Datenquellen einbezieht, und Funktionen, die es erlauben, benutzerdefinierte Funktionen aufzurufen. Die Assistants API ermöglicht es, langanhaltende Konversationen zu führen, indem die Zustandsverwaltung der Gesprächsfäden an OpenAI übergeben wird. Sie ist ab sofort für alle Entwickler in der Beta-Version verfügbar und kann ohne Programmierkenntnisse im Assistants Playground getestet werden. Data und Dateien, die über die API übermittelt werden, fließen nicht in das Training der Modelle ein und können von den Entwicklern nach Belieben gelöscht werden.

Erweiterte Multimodale Fähigkeiten

GPT-4 Turbo mit Vision

GPT-4 Turbo kann jetzt Bilder als Eingaben verarbeiten, um Funktionen wie das Erstellen von Bildunterschriften, die detaillierte Analyse von Bildern und das Lesen von Dokumenten mit Abbildungen zu ermöglichen. BeMyEyes nutzt diese Technologie bereits, um Menschen mit Sehbehinderungen im Alltag zu unterstützen.

DALL-E 3 Integration

Entwickler können DALL-E 3 in ihre Anwendungen integrieren, um direkt Bilder zu generieren. Unternehmen wie Snap, Coca-Cola und Shutterstock verwenden es bereits für die Bildgenerierung in Kundendiensten und Kampagnen.

Text-to-Speech-Optionen

Die Text-to-Speech-API ermöglicht es, menschenähnliche Sprache aus Text zu generieren. Es gibt sechs vordefinierte Stimmen und zwei Modellvarianten, tts-1 für Echtzeitanwendungen und tts-1-hd für höchste Qualität.

Modellanpassung und -spezialisierung

OpenAI führt ein experimentelles Zugangsprogramm für die Feinabstimmung von GPT-4 ein. Erste Ergebnisse zeigen, dass für signifikante Verbesserungen gegenüber dem Basis-GPT-4-Modell mehr Arbeit erforderlich ist als bei der Feinabstimmung von GPT-3.5. Entwickler, die aktiv GPT-3.5-Feinabstimmung nutzen, erhalten die Möglichkeit, sich für das GPT-4-Programm über ihre Feinabstimmungskonsole zu bewerben, sobald Qualität und Sicherheit dies zulassen.

Das eigene GPT Modell

OpenAI führt benutzerdefinierte Versionen von ChatGPT ein, die als GPTs bezeichnet werden und für einen bestimmten Zweck erstellt werden können. Diese personalisierten GPTs können für den täglichen Gebrauch, für spezifische Aufgaben oder zur Freizeitgestaltung angepasst werden und stehen dann der Community zur Verfügung.

GPT-Erstellung ohne Codierung

Jeder kann ohne Programmierkenntnisse ein GPT erstellen, sei es für den persönlichen Gebrauch, für den internen Gebrauch eines Unternehmens oder zum Teilen mit anderen. Das Erstellen eines GPT ist so einfach wie das Starten eines Gesprächs mit spezifischen Anweisungen und Wissensbasen.

GPT Store

OpenAI plant die Einführung eines GPT Stores, in dem Nutzer ihre GPT-Kreationen veröffentlichen können. Dieser Store soll eine Plattform für geprüfte Erbauer bieten, um ihre GPTs suchbar zu machen und gegebenenfalls in Ranglisten aufsteigen zu lassen.

Datenschutz und Sicherheit

Die Privatsphäre und Sicherheit der Nutzerdaten hat Priorität. Chats mit GPTs werden nicht mit den Erstellern geteilt und die Nutzer haben die Kontrolle darüber, ob Daten an Drittanbieter-APIs gesendet werden dürfen. Zudem können Ersteller entscheiden, ob Nutzerchats mit ihrem GPT zur Verbesserung und zum Training der Modelle verwendet werden dürfen.

Anbindung an die reale Welt

Entwickler können GPTs erweitern, indem sie benutzerdefinierte Aktionen durch das Einbinden von einer oder mehreren APIs definieren. Diese Aktionen ermöglichen es GPTs, externe Daten einzubinden oder mit der realen Welt zu interagieren, wie beispielsweise das Anschließen an Datenbanken oder E-Mail-Systeme.

Individuelle Modelle

Für Organisationen, die eine spezifischere Anpassung benötigen, als es die Feinabstimmung bieten kann, startet OpenAI ein Programm für individuelle Modelle. Ausgewählte Organisationen können mit OpenAI-Forschern zusammenarbeiten, um GPT-4-Modelle speziell für ihre Domäne zu trainieren. Dies umfasst Anpassungen des gesamten Trainingsprozesses und exklusiven Zugang zu ihren maßgeschneiderten Modellen. Die Daten zur Trainierung bleiben privat und werden ausschließlich für das individuelle Modell genutzt. Das Programm ist anfangs sehr begrenzt und kostenintensiv. Interessierte Organisationen können sich bewerben.

Fortschritte bei der Befehlsausführung

Aufruf von Funktionen

Function Calling ermöglicht es Entwicklern, Funktionen ihrer Anwendungen oder externer APIs für Modelle zu beschreiben. Das Modell kann dann intelligenterweise entscheiden, ein JSON-Objekt mit Argumenten für den Aufruf dieser Funktionen auszugeben. Neu ist nun die Möglichkeit, mehrere Funktionen in einer einzigen Nachricht aufzurufen. Benutzer können eine Nachricht senden, die mehrere Aktionen anfordert, wie zum Beispiel „Öffne das Autofenster und schalte die Klimaanlage aus“, was zuvor mehrere Interaktionen mit dem Modell erforderte. Zusätzlich wurde die Genauigkeit des Function Callings verbessert: GPT-4 Turbo wählt wahrscheinlicher die richtigen Funktionsparameter aus.

Verbesserte Anweisungsbefolgung und JSON-Modus

GPT-4 Turbo zeigt eine bessere Leistung als frühere Modelle bei Aufgaben, die eine sorgfältige Befolgung von Anweisungen erfordern, wie zum Beispiel das Generieren spezifischer Formate (z.B. „antworten Sie immer im XML-Format“). Außerdem unterstützt es den neuen JSON-Modus, der sicherstellt, dass das Modell mit einem gültigen JSON antwortet. Der neue API-Parameter response_format ermöglicht es dem Modell, seine Ausgabe zu beschränken, um ein syntaktisch korrektes JSON-Objekt zu generieren. Der JSON-Modus ist besonders nützlich für Entwickler, die JSON in der Chat Completions API außerhalb des Function Callings generieren.

Reproduzierbare Ausgaben und Log-Wahrscheinlichkeiten

Der neue seed-Parameter ermöglicht reproduzierbare Ausgaben, indem das Modell konsistente Vervollständigungen liefert. Diese Beta-Funktion ist nützlich für Anwendungsfälle wie das erneute Abspielen von Anfragen zum Debugging, das Schreiben umfassenderer Unit-Tests und allgemein für eine höhere Kontrolle über das Verhalten des Modells. OpenAI hat diese Funktion intern für eigene Unit-Tests genutzt und als sehr wertvoll empfunden. Es wird erwartet, dass Entwickler diese Funktion auf innovative Weise nutzen werden.

In den nächsten Wochen wird auch eine Funktion eingeführt, die die Log-Wahrscheinlichkeiten für die wahrscheinlichsten Ausgabetoken, die von GPT-4 Turbo und GPT-3.5 Turbo generiert werden, zurückgibt. Dies wird nützlich sein für das Erstellen von Funktionen wie Autocomplete in einer Sucherfahrung.

Urheberrechtsschutz durch OpenAI

OpenAI legt großen Wert auf den Schutz seiner Kunden durch integrierte Urheberrechtsicherungen in seinen Systemen. Mit der Einführung des Copyright Shield geht OpenAI nun einen Schritt weiter: Das Unternehmen verpflichtet sich, seine Kunden zu verteidigen und anfallende Kosten zu übernehmen, falls diese mit rechtlichen Ansprüchen wegen Urheberrechtsverletzungen konfrontiert werden. Dies gilt für allgemein verfügbare Funktionen des ChatGPT Enterprise und der Entwicklerplattform. OpenAI zeigt damit sein Engagement für die rechtliche Absicherung der Nutzer seiner KI-Technologien.

Preisreduzierungen und höhere Nutzungslimits

OpenAI hat die Preise für verschiedene Angebote auf seiner Plattform gesenkt, um die Ersparnisse an Entwickler weiterzugeben. Die Preissenkungen sind wie folgt, jeweils pro 1.000 Tokens ausgedrückt:

- GPT-4 Turbo Eingabe-Token sind jetzt dreimal günstiger als bei GPT-4, mit einem Preis von $0.01, und Ausgabe-Token sind zweimal günstiger, zu einem Preis von $0.03.

- GPT-3.5 Turbo Eingabe-Token sind dreimal günstiger als beim vorherigen 16K-Modell, mit einem Preis von $0.001, und Ausgabe-Token sind zweimal günstiger, zu einem Preis von $0.002. Entwickler, die bisher GPT-3.5 Turbo 4K genutzt haben, profitieren von einer 33%igen Reduktion bei Eingabe-Token zu einem Preis von $0.001. Diese niedrigeren Preise gelten nur für das heute eingeführte neue GPT-3.5 Turbo.

- Feinabgestimmte GPT-3.5 Turbo 4K-Modell Eingabe-Token sind viermal günstiger, zu einem Preis von $0.003, und Ausgabe-Token sind 2,7 mal günstiger, zu einem Preis von $0.006. Feinabstimmung unterstützt jetzt auch einen 16K-Kontext zum gleichen Preis wie 4K mit dem neuen GPT-3.5 Turbo-Modell. Diese neuen Preise gelten auch für feinabgestimmte gpt-3.5-turbo-0613-Modelle.

Die Preisänderungen werden in einer Gegenüberstellung der alten und neuen Modelle zusammengefasst, um die Unterschiede hervorzuheben.

Erhöhung der Nutzungslimits

Um die Skalierung von Anwendungen zu unterstützen, verdoppelt OpenAI das Token-pro-Minute-Limit für alle zahlenden GPT-4-Kunden. Die neuen Nutzungslimits können auf der entsprechenden Seite des Benutzerkontos eingesehen werden. Außerdem wurden die Nutzungsebenen veröffentlicht, die automatische Limitsteigerungen bestimmen, sodass Entwickler wissen, was sie hinsichtlich der Skalierung ihrer Nutzungslimits erwarten können. Anfragen zur Erhöhung der Nutzungslimits können nun über die Kontoeinstellungen gestellt werden.

Fazit

Die Fortschritte in der künstlichen Intelligenz, insbesondere mit der Einführung von GPT-4, kündigen ein neues Zeitalter an, in dem halbautonome Agenten zunehmend eine Rolle in unserem Alltag spielen werden. Die „dünnen“ Wrapper, die einst als Bindeglied zwischen uns und den KI-Modellen fungierten, werden durch direktere und intuitivere Interaktionen mit den Modellen selbst ersetzt. Diese Entwicklung ermöglicht es den Modellen, selbstständig zu handeln und aus Interaktionen zu lernen, wodurch sie effizienter und adaptiver werden.

OpenAI hat auf dem Developer Day eine Vision für die Zukunft präsentiert, in der KI-Modelle nicht nur als leistungsfähige Werkzeuge für Entwickler dienen, sondern auch als Agenten, die neben menschlichen Anwendern stehen. Diese Agenten sollen mit fortschrittlichen Funktionen wie verbesserter Speicherung, Autonomie und effizienterer Werkzeugnutzung ausgestattet sein, was sie in die Lage versetzt, eigenständige Entscheidungen zu treffen und komplexe Aufgaben mit weniger menschlichem Eingriff zu bewältigen.

Für Unternehmen bedeutet dies, dass sie die KI tief in ihre Produkte integrieren müssen, um wettbewerbsfähig zu bleiben. Diejenigen, die jetzt in ChatGPT investieren und ihre Dienstleistungen darum aufbauen, werden in der neuen Ära führend sein. Für Nutzer bedeutet dies eine erhebliche Zeit- und Kostenersparnis, da anstelle vieler spezialisierter Werkzeuge zunehmend auf eine einzige, leistungsstarke KI-Plattform zurückgegriffen werden kann. Die Zukunft verspricht eine Transformation unserer Arbeitsweisen und eine Neuausrichtung unserer Vorstellungen von Effizienz und Produktivität.

Die Roadmap von OpenAI deutet darauf hin, dass wir auf eine Welt hinarbeiten, in der Agenten in der Lage sein werden, autonom zu planen und zu handeln, und das Konzept der Autonomie subtil umschreiben, ohne das Wort direkt zu verwenden. Die Schaffung von AGI wird nicht nur durch die Entwicklung des Kernmodells, sondern auch durch die Erweiterung der Modelle mit zusätzlichen Werkzeugen und Strukturen erreicht.

In dieser sich rasch entwickelnden Technologielandschaft ist es an der Zeit, dass wir nicht nur Zeuge der KI-Revolution werden, sondern aktiv an ihrer Gestaltung teilnehmen. Die Richtung ist klar: Es geht hin zu einer Welt, in der KI-gesteuerte Agenten und Systeme, die autonom agieren können, eine zentrale Rolle spielen werden. Dieser Wandel wird nicht nur unsere Arbeitsweise, sondern auch unsere Wirtschaft und Gesellschaft grundlegend verändern.

Quellen